SmartMoE:清华大学PACMAN实验室发布

2023年7月,清华大学计算机系PACMAN实验室发布了稀疏大模型训练系统SmartMoE. 这个系统支持用户一键实现Mixture of Experts(MoE)模型的分布式训练,并通过自动搜索复杂并行策略来达到领先性能. 同时,PACMAN实验室在国际顶级系统会议USENIX ATC’23上发表了长文,这篇论文的通讯作者是翟季冬教授,作者包括博士生翟明书和何家傲等. SmartMoE是PACMAN实验室在机器学习系统领域持续深入研究的成果之一,它是继FastMoE、FasterMoE和"八卦炉"之后在大模型分布式训练系统上的又一次探索。想要了解更多相关成果,训练管理系统可以访问翟季冬教授的个人主页.

MoE技术的背景和挑战

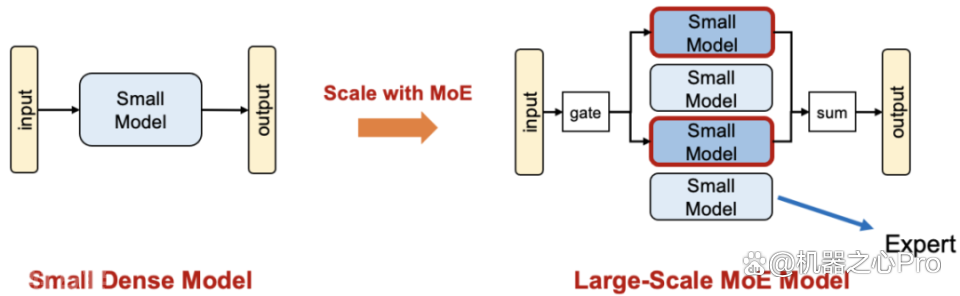

Mixture of Experts(MoE)是一种模型稀疏化技术,因其高效扩展大模型参数量的特性而备受研究者关注. 与稠密模型通过增大模型尺寸来扩展不同,MoE技术通过将一个小模型转变为多个稀疏激活的小模型实现参数扩展。每个小模型专门处理输入的某一部分,并将结果合并以获得最终的预测。由于各个专家在训练时稀疏激活,MoE模型可以在不增加每轮迭代计算量的前提下增加模型参数量,从而有望在相同训练时间内获得更强的模型能力。

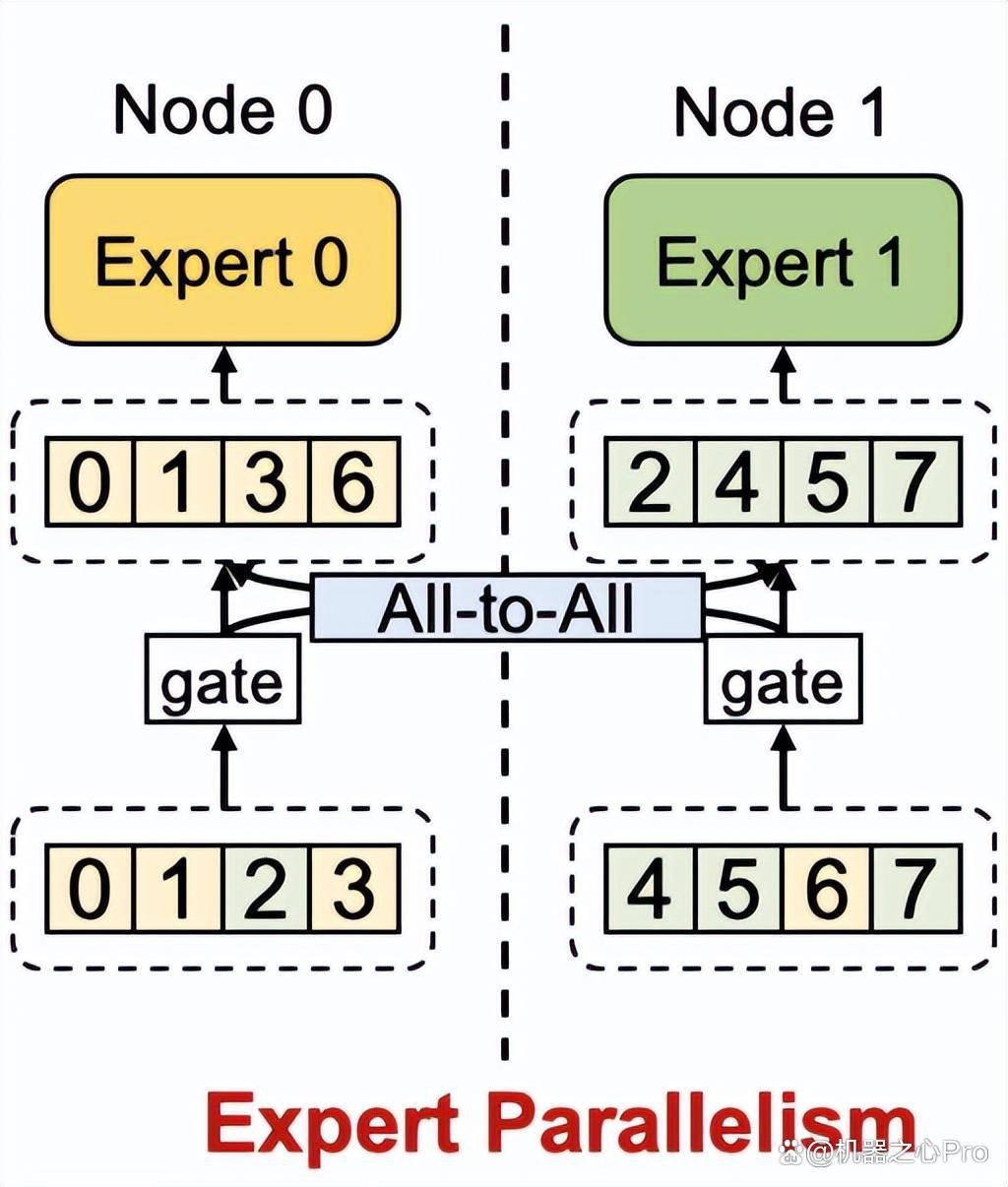

然而,要实现MoE大模型的分布式训练存在一些挑战. 专家并行是业界提出的一种解决方案,但在面对稀疏和动态计算模式带来的性能问题时,仍然存在一定的局限性. 为了解决这些问题,PACMAN实验室进行了深入的研究.

SmartMoE:稀疏大模型训练系统

为了提高MoE模型的易用性和训练性能,PACMAN实验室开发了SmartMoE系统. 该系统是基于PyTorch的MoE分布式训练系统的开源实现,于2021年初发布了FastMoE系统,成为业界的研究热点。进一步,PACMAN实验室在FasterMoE系统中分析并优化了专家并行策略,解决了稀疏和动态计算模式带来的性能问题。其中,"影子专家"技术缓解了负载不均问题,而通信-计算协同调度算法有效隐藏了all-to-all通信的高延迟. FasterMoE的成果发表在PPoPP'22国际会议上.

而SmartMoE系统在此基础上进一步探索,通过自动搜索复杂并行策略,达到了开源MoE训练系统领先性能的目标. 它为用户提供了一键式的MoE模型分布式训练支持,简化了操作流程,训练管理系统提高了使用效率. 通过SmartMoE系统,研究人员和开发者可以更方便地应用MoE技术进行大规模模型训练,提升模型的性能和效果.

结语

PACMAN实验室在稀疏大模型训练系统上的研究取得了一系列重要成果. 从FastMoE到FasterMoE,再到现在的SmartMoE,他们不断推动着MoE技术在分布式训练领域的发展. 通过这些系统的研究和优化,MoE模型的易用性和训练性能得到了显著提升.

未来,PACMAN实验室将继续深入研究机器学习系统领域,不断探索更多创新的方向。我们期待着他们在大规模模型训练和分布式计算方面的更多突破,为机器学习技术的发展做出更多贡献. .

咨询在线QQ客服

咨询在线QQ客服